数据去重

主数据

黄金记录

数据去重

数据去重主要涉及ETL或ELT过程。

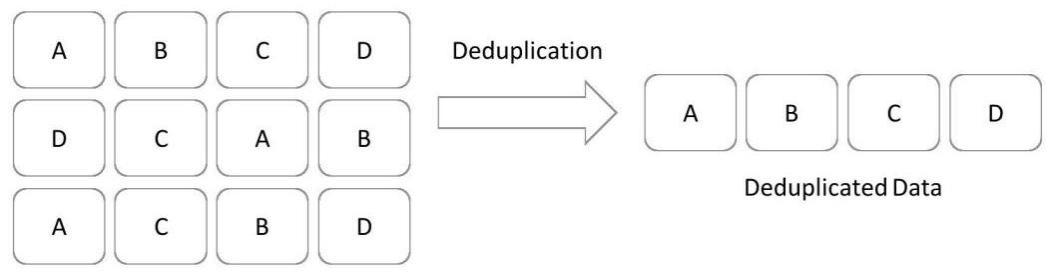

数据去重是指删除数据中的重复部分。

有两种类型的数据可以复制,即:

1) 原始或者处理的数据

2) 黄金记录的缺失

类型:

1.原始或处理过的数据:在这种类型的数据中,有许多方式会产生重复数据,但以下是导致大多数重复数据生成的两个主要原因。

(1) 从前端应用程序输入的数据,例如当系统设计得非常糟糕,允许输入重复数据,例如错误地创建了两次客户或销售了一次产品,但系统允许多次输入,因为人为错误。这些数据必须作为数据质量过程的一部分被删除。

(2) ETL/ELT过程中,数据从源系统转换到数据仓库、数据集市或语义层等。这些数据也需要通过数据质量过程进行清除。

2.黄金记录的缺失:当金牌记录缺失时,重复数据也会出现。什么是黄金记录?黄金记录的缺失意味着单个实体有多个代码,例如,考虑一个保险公司在一个系统中使用001作为保单代码,在第二个系统中使用002,在第三个系统中使用003,现在当来自这三个系统的数据流入一个中心位置,可以是数据仓库或数据集市,将会有与每个保单相关的交易,但实际上所有保单都属于同一类型的保单。当这些数据传递给市场部门并且他们计划发送在线活动时,他们不会只发送一个针对某种政策类型的活动,而是会设计三个针对同一种政策类型的活动。这种情况可以通过去重的黄金记录和主数据管理(MDM)应用程序来处理。